小米技術新突破!具身大模型 MiMo-Embodied 正式發布并全面開源

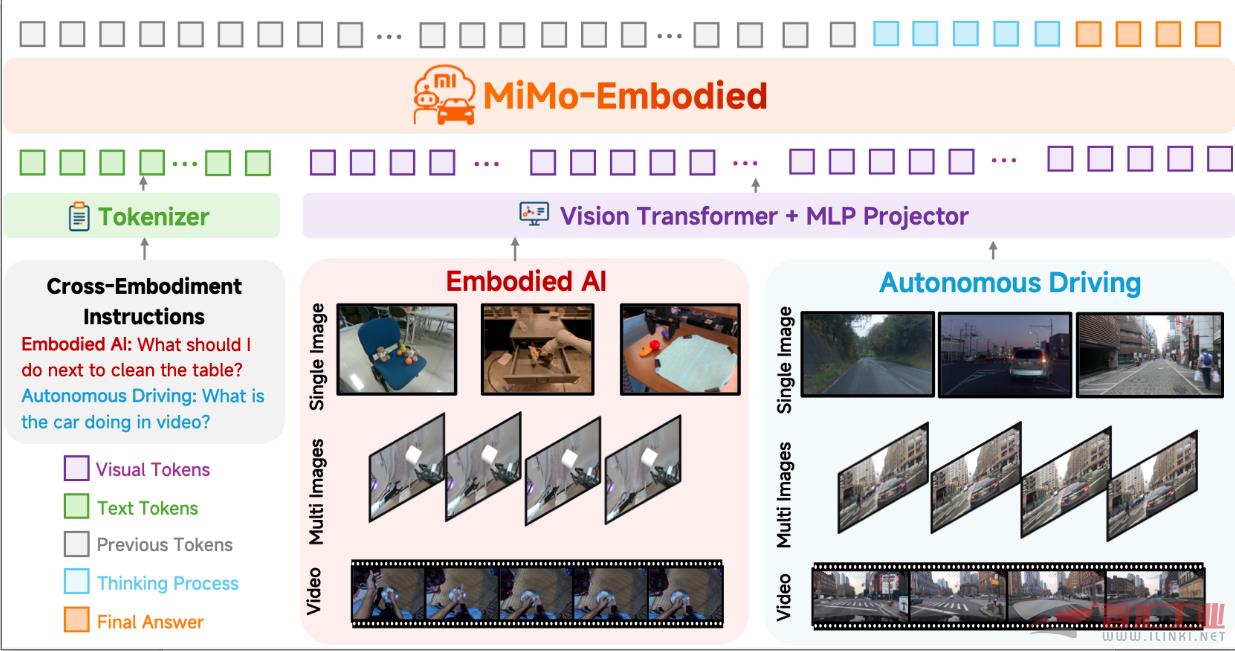

隨著具身智能逐步落地家居場景、自動駕駛技術邁向規模化應用,行業內一個關鍵問題日益凸顯:機器人與車輛如何更好地實現認知與能力互通?室內作業智能與室外駕駛智能能否實現相互促進?為此,我們重磅推出 —— 具身大模型「MiMo-Embodied」。

作為業界首個成功打通自動駕駛與具身智能的跨域具身基座模型,它實現了兩大領域任務的統一建模,標志著通用具身智能研究從 “垂直領域專用” 向 “跨域能力協同” 邁出關鍵一步。為推動社會對通用具身智能范式的進一步探索,該模型現已全面開源。

三大核心技術亮點

跨域能力覆蓋:同步支持具身智能三大核心任務(可供性推理、任務規劃、空間理解)與自動駕駛三大關鍵任務(環境感知、狀態預測、駕駛規劃),形成全場景智能支撐;

雙向協同賦能:驗證了室內交互能力與道路決策能力的知識轉移協同效應,為跨場景智能融合提供了新的思路;

全鏈優化可靠:采用 “具身/自駕能力學習→ CoT 推理增強→RL 精細強化” 多階段訓練策略,有效提升模型在真實環境中的部署可靠性。

雙領域 SOTA 與范式驗證

在涵蓋感知、決策與規劃的 29 項核心基準測試(Benchmarks)中,MiMo-Embodied 確立了開源基座模型的性能新標桿,全面優于現有的開源、閉源及專用模型:

具身智能領域:在 17 個 Benchmarks 上取得 SOTA 成績,重新定義了任務規劃、可供性預測及空間理解的能力邊界;

自動駕駛領域:在 12 個 Benchmarks 上表現卓越,實現了環境感知、狀態預測與駕駛規劃的全鏈路性能突破。

通用視覺語言領域:在夯實通用感知與理解能力的同時,進一步在多項關鍵基準上實現了顯著的性能躍升,展現了卓越的泛化性。

從家庭場景到城市道路,MiMo-Embodied 正推動智能技術向 “可用、可信、可擴展” 的現實世界穩步邁進,為小米人車家全生態注入核心技術動能!

模型與代碼現已開源,歡迎全球開發者與研究人員共同參與,探索具身智能的無限可能~

技術報告:https://arxiv.org/abs/2511.16518

開源代碼:GitHub - XiaomiMiMo/MiMo-Embodied: MiMo-Embodied

MiMo-Embodied 模型:https://huggingface.co/XiaomiMiMo/MiMo-Embodied-7B

(審核編輯: 光光)

分享