最近 ChatGPT 占據了各大新聞板塊頭條,國內外各大公司陸續跟進。無論是不是AI相關人士,都躍躍欲試要搞個賬號來玩一把。一時之間,ChatGPT 點燃了整個互聯網,人們為之興奮,討論著如科幻小說里的未來,OpenAI 這家公司一時風光無兩。

作為一個非 AI 從業者,我不懂 ChatGPT 用到的算法和模型,但我嘗試從一些我了解的方向——云計算和分布式系統——來談談 OpenAI 的架構和技術路線。

首先,根據公開資料,OpenAI 的 ChatGPT 和其他關鍵 AI 產品依賴于微軟 Azure 云計算服務,多年來微軟共對 OpenAI 進行了共上百億的投資,這些資金幫助 OpenAI 在 Azure 云平臺上運行和訓練其模型(有傳聞說微軟一部分投資以云計算服務交付的,但我沒有找到具體的資料)。

OpenAI 的所有模型和算法——包括 ChatGPT、Codex(類似于 Github Copilot)和 Dall-E 2(人工智能繪畫)都獨家運行在 Azure 上,通過 Azure 的 HPC、彈性、數據存儲和計算服務來完成模型計算和算法調試;當 OpenAI 的產品成熟后,除了可以公開 to c 使用,還可以作為 Azure 的一項 PaaS 服務 Azure OpenAI Service 來售賣,企業或個人可以通過 OpenAI 的 API 來開發自己的人工智能應用——而微軟當然是首先吃螃蟹的人,最近微軟已經宣布全線產品整合 ChatGPT,并且已經推出基于 ChatGPT 的 New Bing(這顯然嚇壞了 Google),和基于 Dall-E 2 的 Microsoft Designer。

這是一種完美的相輔相成、合作共贏的商業模式。

也許我們可以這么理解,OpenAI 基于 Cloud Native 來做應用開發,基于云計算提供的方便的高性能計算來運算模型和打磨算法,并對外銷售產品和 API;而微軟基于 AI Native 來提升搜索、繪畫、Github 等產品,未來我們應該還可以在 Office,Teams,甚至操作系統等微軟產品中用到 OpenAI 提供的能力。

一邊是 Cloud Native 做開發,一邊是 AI Native 做產品。

new Bing with AI 讓 Google 徹底慌了

這種 Cloud + AI 的商業模式,其實也并不新鮮,我們在開源數據庫、開源中間件上就見過 Cloud + Infra 模式,但由于 AI 對于大量算力的需求使其從開始就考慮 Cloud Native(開源軟件的研發并不強需要云,開發者在自己的電腦上也能編譯運行),而由于其產品可以直達普通用戶(開源軟件難以引起如此轟動),組合起來才產生了如此巨大的影響力,以至于各大全公司紛紛跟進 AI Native。

據傳 OpenAI 運算一次成本非常昂貴,我們可以想象自建一個算力如此巨大、GPU 如此之多的數據中心需要多大的成本,以及需要額外付出多少運維運營成本,而直接“租用” Azure 的基礎設施,按量付費,可以有效地節省早期的支出,并且縮短早期創業啟動期,將研發的時間投入到真正有價值的事情。

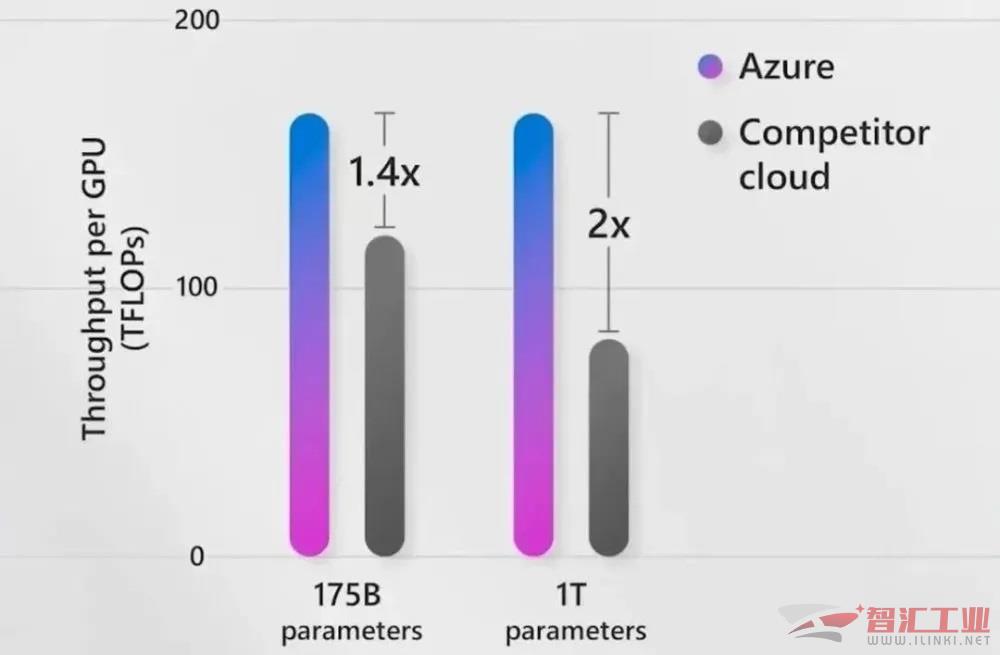

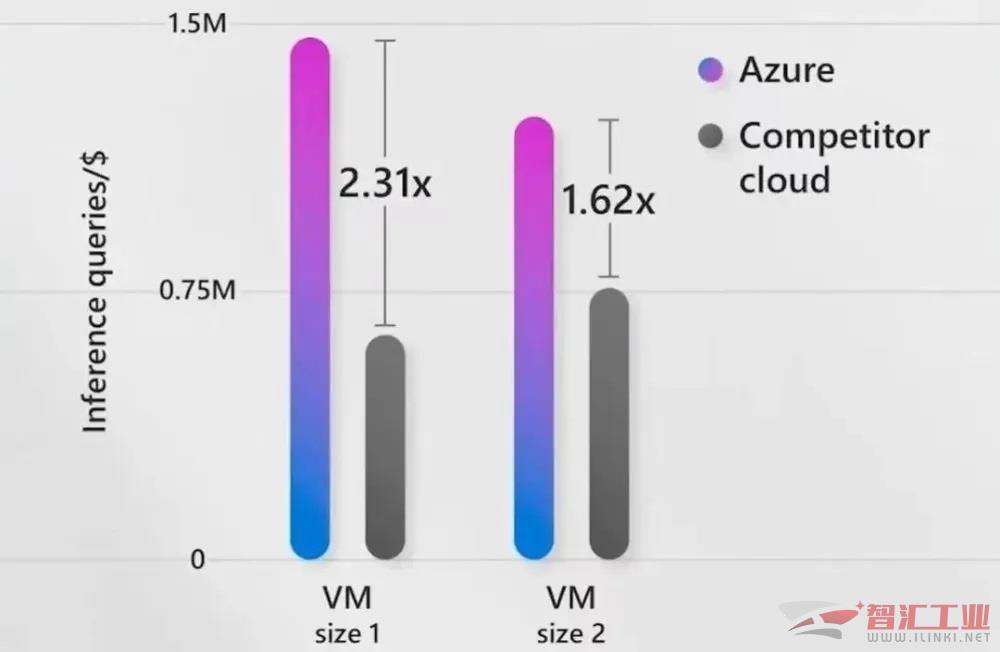

圖示為 AI 場景下各家云廠商 VM 性能對比,Azure占優。

我們可以根據公開資料看看 ChatGPT 會用到哪些云服務(網絡、安全組等等就不說了)。首先是高性能計算 HPC 作為算力基礎。其次 ChatGPT 作為一個 web 服務,會使用一些基礎的云服務器,并且受益于云的彈性,作為一個 to c 服務,ChatGPT 可以根據請求流量自動彈性伸縮計算、存儲和網絡資源;當請求減弱時,可以適當釋放資源以節省成本。

另外,根據資料,ChatGPT 還使用了云數據存儲和計算服務,包括:

Azure SQL Database 和 PostgreSQL,數據庫用來存儲結構化數據,例如模型相關的語料和文本;

Azure Blob Storage,用來存儲非結構化數據;

以及數據湖存儲 Azure Data Lake Storage,用來存儲各種非結構化數據、半結構化和結構化數據;

同時 OpenAI 還可以使用云上類似 Hadoop 之類的計算引擎來進行分布式計算,以加速模型計算任務和提升負載。

想象一下,在沒有云計算的時代,干這么一件事所需要的成本,不僅需要自建機房提供計算、存儲和網絡,還要自己維護一堆 PaaS 服務,其啟動成本讓人望而卻步。

OpenAI 不僅展示了 AI 的強大,也從底層展現了云計算的重要性。要是沒有云計算,我想 OpenAI 沒有這么快做出 ChatGPT。

也許,未來的互聯網應用在服務上 Cloud Native,在產品上 AI Native。

(審核編輯: 諾謹)

分享